机器学习模型面试问题

1、gbdt与xgb选择分裂点的时候使用的是什么? gbdt MSE;xgb ? 对应的一个公式

https://blog.csdn.net/zxf2ld/article/details/125645529

图方面:

- 同构,LPA、Louvain、PageRank

- Louvain,模块度最大化,https://zhuanlan.zhihu.com/p/556291759

- LPA https://blog.csdn.net/qq_34160248/article/details/126804687

- 核心是如何不漏过主要问题,而限缩计算;是节点建立;

- 假设为核心,比如使用粉丝关系去计算,本质上是认为黑产粉丝之间是互相关注的;

- 最后跑出来的团伙,其实就是团;

- 对于预制黑标签,扩散,其逻辑本质就是如果一个团伙关系紧密,团伙中有一部分黑的,则把整个团伙染色;

- 二部图LPA

- 关系构建,一般的设备关联、想通节点关联;弱关系,强关系;

- 行为也可以关联;比如,用户下单商家;可以有强弱计算方法

- 文本内容关联: 比如找商家店员身份,基于收货地址和商户名称

- 暗号;

- 密集子图:连通图,k-core, fraudar, biclique等

- SynchroTrap; 基于行为构建的同步行为用户组,本质就是行为相似度;基于时间的

2024.2.28

面试经典问题回答

你觉得你们业务当前遇到的困难时什么?

- 我个人是眼里容不下问题的,所以能解决的问题我全部都解决了;

- 我也肯定知道那些短期不可能解决好的问题,比如XX不太智能,XX效率还是比较低;比如验证效率比较低,应该更智能化。策略阈值需要人工设定,可以通过算法XX;

- 那具体真正的问题,还是风控的核心问题;风险预防与业务价值;

- 当然还有组织结构的问题,包括分工不合理等;这些不是我说了算,只能做到能做到的地方。

未来工作的诉求是什么?

- 对我来说诉求就是能让自己发挥价值的地方;毕竟这个行业干了这么多年,现在拥有的技能不想浪费掉;可能听起来有点虚。

Opay面试

- 训练集和验证集效果好,但是测试机效果不好;是什么问题?

- 特征存在偏移

- 测试集特征与训练集不一致;

- 对比特征分布是否一致; 如KL散度

- 测试集特征与训练集不一致;

- 样本选择出现偏差

- 验证集和测试集不符合独立同分布

- 特征存在偏移

- 深度学习哪些防止过拟合的方法?

- dropout

- 正则化w, l1,l2

- batchNormalize

- LayerNormalize

- 减少层数和个数,降低学习率

- early stopping

- 增加数据量: 数据增强,如图像旋转、裁剪等

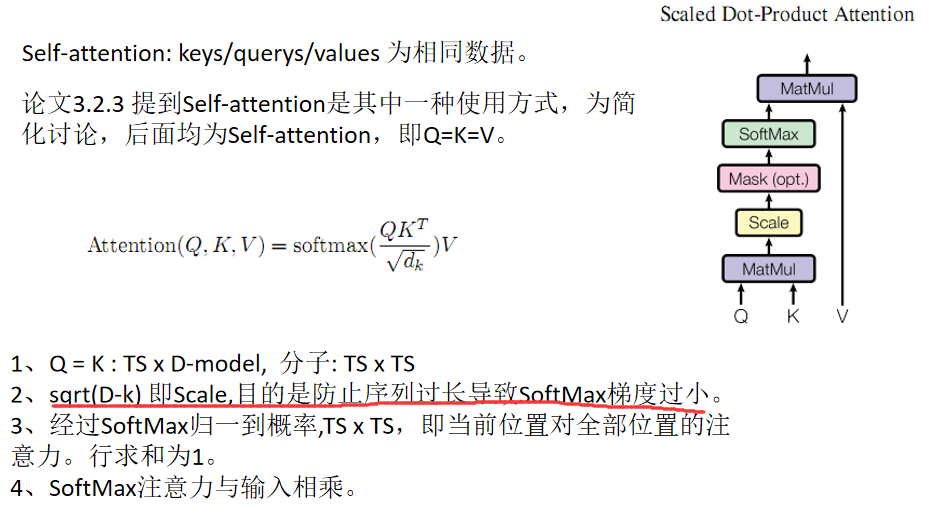

- transformer简单介绍,self-attention除以 根号d 是什么作用?

- Q x K得出的是序列的不同位置间的相关性;

- softmax,数值过大过小,梯度都比较小;统一除以sqrt(d-k)常数,缩小量纲,可以加快训练速度;

- BN 有什么作用?

- 好处

- 更快的收敛

- 减轻对初始化参数的依赖

- 增加泛化能力,降低过拟合风险

- 缺点:

- batch较小时效果比较差;

- 不适用于rnn;

- LayerNormalize

- 不依赖batch

- 适用于rnn

- 好处

百度面试:

- bert的任务是什么?NSP(next sentence predict) MLM(masked language model)

- bert的损失函数是什么?

- MLM使用softmax计算单词的概率,交叉熵损失

- NSP使用简单的分类,IsNextSequene,其实也是交叉熵损失

- 他说,beart后来把NSP这种方法不怎么用了?为什么?NSP有什么缺点

- 其实是RoBERTa,去掉了NSP任务;

中国星网:

- bert与transformer的损失函数区别?

- 先确认transformer; https://www.cnblogs.com/mxleader/p/17828540.html

- BERT的模型结构是Seq2Seq,核心是Transformer encoder;

- bert为什么没有使用multi-head,只使用一个head?

- 先确认;

小米:

- 编程题

- [-9, -7, -3, 0, 1,1, 5,6] 找出绝对值只出现一次的个数

- 方法:两边往中间合并;

小红书:

- 编程题

- 爬楼梯1,一次只能爬1阶,2阶,3阶;

- 爬楼梯2,一次只能爬k阶;https://blog.csdn.net/qq_40905198/article/details/102491844

小红书:电商风控一面

- 编程题

- 找出0-100间的质数

京东广告反作弊:

- 快速排序;

- 0-9号牌,十个人;有放回出来3个人,求满足年龄依次变小的概率;

- C(3,2)+C(4,2)+…+C(9,2);先确定第3个人,再从剩余里取2个人即可,考虑顺序;

- fraudar算法的核心是什么? 是不是用户相似度;

数字人民币研究所:

- xgb学习率过大会存在什么问题?

- 每棵树的贡献赋予了更大的权重,但这可能会导致过拟合/不稳定,会加快训练时间。而较低的学习率抑制了每棵树的贡献,使学习过程更慢但更健壮。

- bert对长文本有什么缺点? 【这问题很垃圾】,

- 如果文本长度超1000字符,怎么办? https://blog.csdn.net/weixin_43815222/article/details/136204450

- 截断,前截断、尾截断、前+尾

- pooling,切分过多个bert,再加一层合并

- 压缩,去除无用部分

- 对于风控任务,往往是整段话中有一小块敏感的就都要抛弃;而使用bert会通篇考虑语义,弱化黑的部分;所以,黑词很有效;第二就是,截断判断,有一段有问题整片拒绝

- 如果文本长度超1000字符,怎么办? https://blog.csdn.net/weixin_43815222/article/details/136204450

金融风控

1、PSI模型稳定度指标(population stability index ,PSI)可衡量测试样本及模型开发样本评分的的分布差异,为最常见的模型稳定度评估指针。https://blog.csdn.net/m0_54231818/article/details/134788210

2、KS统计量 https://zhuanlan.zhihu.com/p/140766729 ; 累积正例占比 减去 累积负例占比的最大值,说明对于正负样本的区分能力;

3、xgb特征重要性,weight 特征的使用次数,gain 特征的平均增益,cover特征对样本的平均覆盖度;

4、IV(Infromation Value),信息价值,用来表示特征对目标预测的贡献程度,即特征的预测能力,一般来说,IV值越高,该特征的预测能力越强,信息贡献程度越高。由于IV值的计算是以WOE值为基础的,所以计算IV值之前,首先得计算WOE值。

https://blog.csdn.net/lu_yunjie/article/details/109530875